LLM 的“幻觉”

就像所有技术一样,尽管当前的大语言模型 (LLM) 在各个领域都表现出色,但它们也并非完美无缺,存在一些固有的缺陷和局限性。“幻觉 (Hallucination)” 就是 LLM 中一种非常常见的缺陷。

什么是“幻觉”?

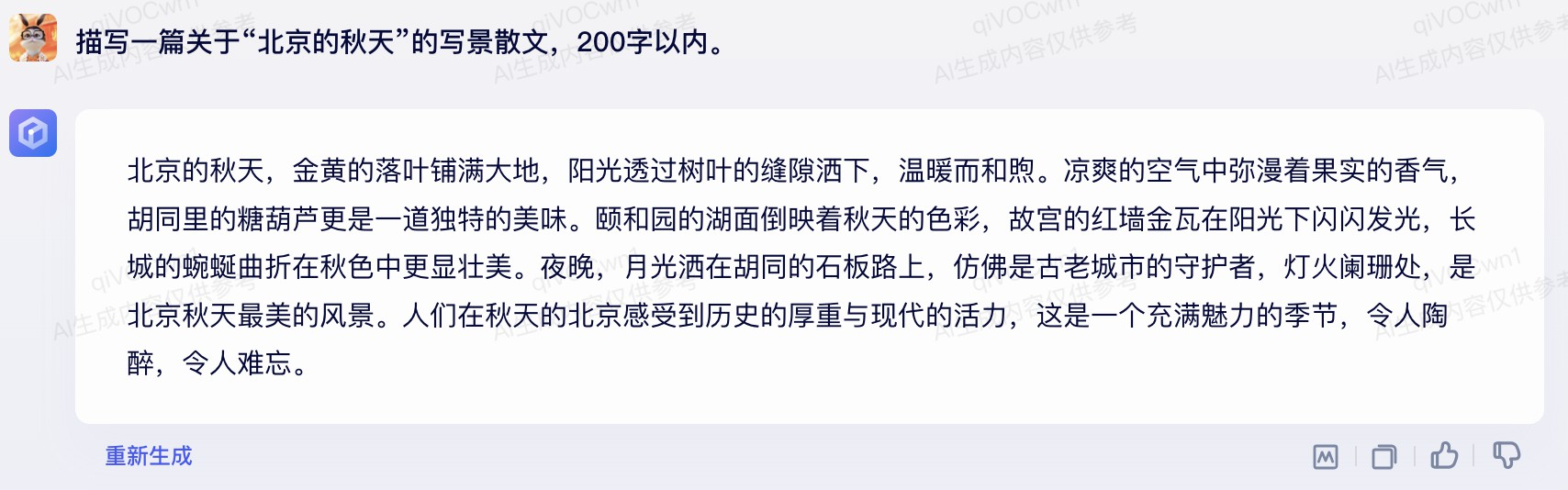

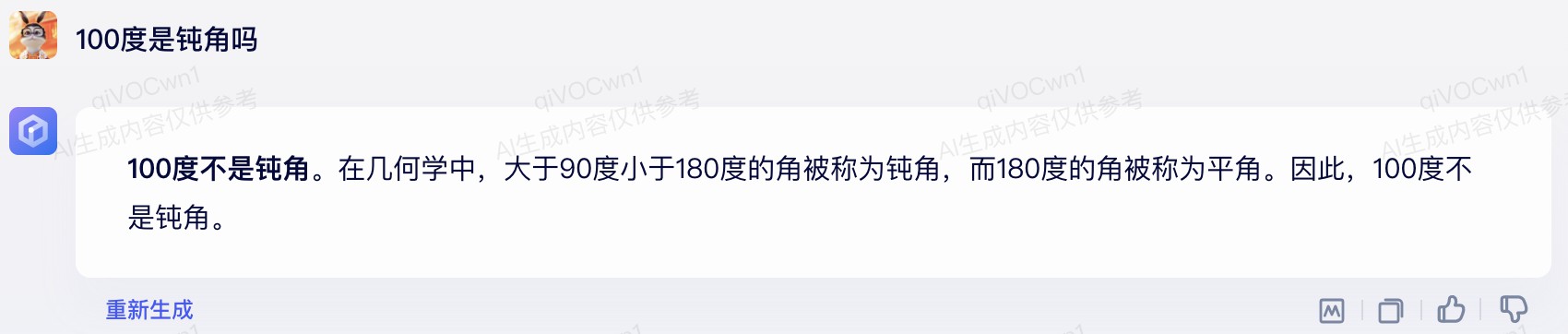

幻觉 是自然语言生成 (NLG) 领域的一个术语,指的是模型生成了看似合理但实际上并不存在的内容。 这些内容可能包含虚构的信息、前后矛盾的逻辑,甚至是毫无意义的胡言乱语。

幻觉 最初是心理学中的一个术语,用于描述一种特殊的知觉体验:在没有外部刺激的情况下,清醒的人产生的虚假感觉。

幻觉 是一种不真实的、却又让人感觉真实的虚幻感知。 模型容易生成流畅但缺乏真实性的内容,这种现象与心理学中的 幻觉 非常相似,因此在 LLM 领域,我们把 LLM 的这种缺陷称之为 幻觉。

“幻觉”会严重影响依赖 LLM 的下游业务的表现,导致这些业务在实际应用中无法满足用户需求。 因此,大语言模型生成内容的真实性是生成式模型未来需要解决的重要科学问题之一。

“幻觉”通常可以分为两类:

- 内在幻觉 (Intrinsic Hallucinations): 生成的内容与输入的原始信息相冲突。

- 外在幻觉 (Extrinsic Hallucinations): 生成了与原始信息无关的内容。 外在幻觉可能与事实相冲突,也可能不冲突。 在某些情况下,符合事实的外在幻觉可能会更好,但实际情况往往并非总是如此。