想在 Windows 上玩转 Ollama?看这篇就够了!(超详细图文教程)

嘿,朋友!想不想在自己的 Windows 电脑上,不用联网也能跑各种酷炫的大语言模型(LLM)?那 Ollama 这个神器你可不能错过!

别担心自己是技术小白,这篇指南就是为你量身打造的。咱们会一步步带你搞定下载、安装、配置,还有怎么验证它是不是乖乖工作了。保证让你轻松上手,在本地畅玩 AI 大模型!

咱们要做啥?简单来说就这几步:

- 去官网把它“请”回来 (下载安装包)

- 给它安个家,顺便设置点“规矩” (配置环境变量,特别是模型放哪儿)

- 启动它,让它开始“干活” (运行 Ollama 服务)

- 检查一下,确保一切 OK (验证安装)

准备好了吗?Let's Go!

第一步:下载和安装 Ollama

直奔官网下载:

- Ollama 下载直通车:https://ollama.com/download

- 想了解更多?看看官网主页:https://ollama.com

- 爱折腾的同学可以去 GitHub 仓库瞅瞅:https://github.com/ollama/ollama/

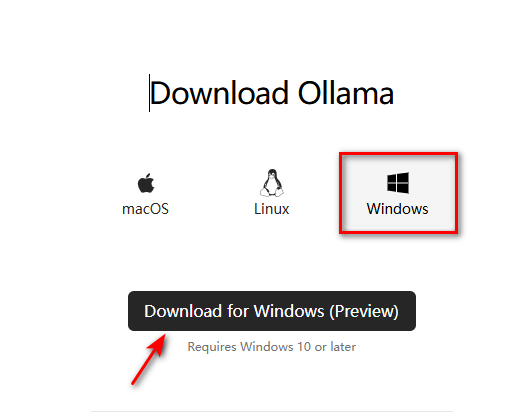

打开下载页面,那个大大的 "Download for Windows" 按钮应该很显眼。点它!浏览器就会开始下载一个叫

OllamaSetup.exe的文件。

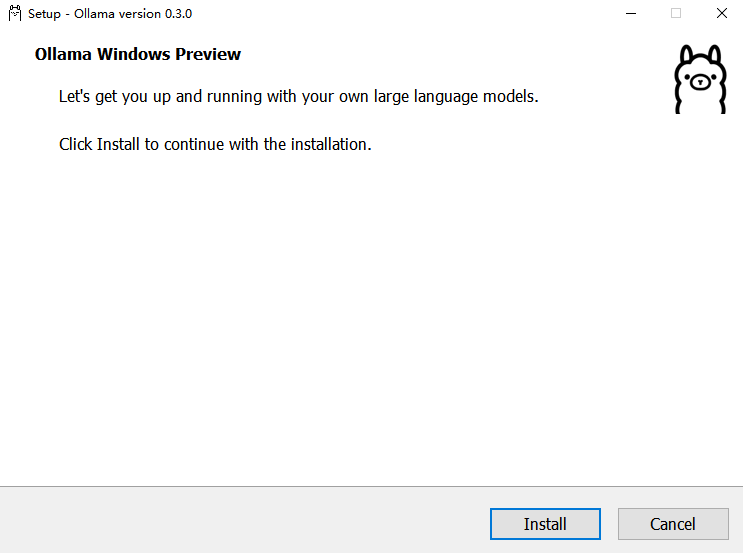

无脑式安装: 下载完成后,找到

OllamaSetup.exe,双击它。弹出来的窗口里,直接点 "Install" 就行。接下来,耐心等它自己跑完安装进度条。它会自动把需要的东西都准备好。

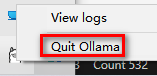

安装完成,它可能自己就启动了: 安装结束后,Ollama 通常会悄悄在后台启动。你可以在电脑右下角的任务栏通知区(就是显示时间、网络图标那里)找到 Ollama 的小图标。右键点它,可以选 "Quit Ollama" 把它关掉,或者点 "Logs" 看看它的运行日记。

第二步:配置环境变量 (这一步超关键!)

装好了 Ollama,强烈建议你花几分钟配置一下环境变量。这能让你更好地“指挥”Ollama,比如,告诉它模型文件应该存到哪里去。

“环境变量”是啥玩意儿?

简单说,它就像是给电脑系统贴的一些“小纸条”,上面写着一些配置信息。程序(比如 Ollama)可以读取这些“纸条”,知道自己该怎么运行,东西该放哪儿等等。

几个 Ollama 常用的“小纸条”:

| 变量名 (纸条名称) | 说明 (纸条内容) | 咱们的建议 |

|---|---|---|

OLLAMA_MODELS | 模型仓库位置! 默认它会把下载的模型塞到 C 盘你的用户文件夹下(类似 C:\Users\你的用户名\.ollama\models)。强烈建议挪到其他盘(比如 D 盘、E 盘)! 不然模型一大,C 盘空间就告急了! | 比如,放到 E:\ollama\models (记得先建好 E:\ollama 这个文件夹) |

OLLAMA_HOST | 谁能访问 Ollama? 默认是 127.0.0.1,意思是只有你自己这台电脑能用。如果你想让局域网里的其他设备(比如手机、平板或其他电脑)也能连上它,就改成 0.0.0.0。 | 想局域网共享就设 0.0.0.0,否则默认就好 |

OLLAMA_PORT | Ollama 服务的“门牌号”。 默认是 11434。如果这个“门牌号”被其他程序占用了,Ollama 就启动不了。到时候可以换个没被用的号码(比如 8080)。 | 默认 11434,真冲突了再改 |

OLLAMA_ORIGINS | 允许哪些“访客”(HTTP 客户端)来敲门。一般用不到特别设置,想省事可以直接设成 *,表示谁来都欢迎。 | 本地用就设 * 吧 |

OLLAMA_KEEP_ALIVE | 模型加载进内存后能“待机”多久? 默认是 5m (5分钟)。时间到了没人用,模型就从内存里卸载了,下次用又要重新加载。可以设成纯数字(单位是秒),0 表示用完立刻“走人”,负数表示“赖着不走”。想让反应快点?建议设长一点,比如 24h (24 小时)。 | 追求速度就设 24h |

OLLAMA_NUM_PARALLEL | 同时能处理多少个请求。默认 1。电脑配置好可以适当调高。 | 看你电脑性能,默认一般够用 |

OLLAMA_MAX_LOADED_MODELS | 内存里最多同时“住”几个模型。默认 1。如果你经常切换着用不同模型,可以调高点,但会更吃内存。 | 内存够大且有需要再调整 |

OLLAMA_DEBUG | 要不要看超详细的运行日志?调试时可以设成 1。 | 遇到问题需要排查时设 1 |

OLLAMA_MAX_QUEUE | 请求排队的最大长度。默认 512。一般不用改。 | 默认就好 |

怎么设置这些“小纸条”(环境变量)?

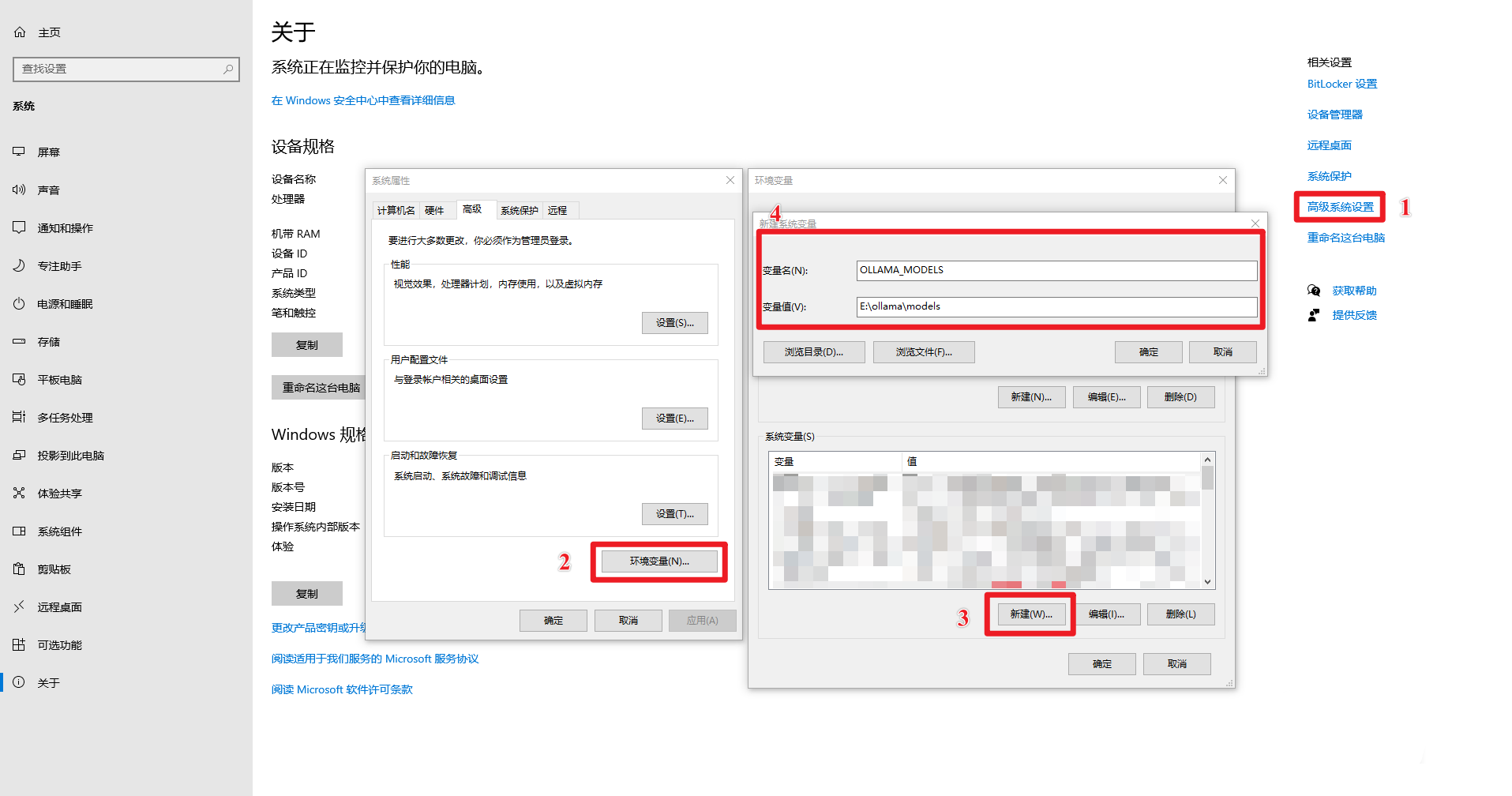

找到设置的地方:

- 最快的方法:在 Windows 搜索框里搜“环境变量”,然后点“编辑系统环境变量”。

- 或者:右键点“此电脑” -> “属性” -> “高级系统设置” -> “环境变量”。

- 再或者:控制面板 -> 系统和安全 -> 系统 -> 高级系统设置 -> 环境变量。

- 还可以:按

Win + R键,输入sysdm.cpl回车,去“高级”选项卡,点“环境变量”。

新建“小纸条”: 在弹出的“环境变量”窗口里,找到下面的“系统变量”区域(如果你只想让当前用户生效,也可以选上面的“用户变量”),然后点“新建”。

写上“纸条名称”和“内容”:

- 在“变量名”里输入上面表格里的名称,比如

OLLAMA_MODELS。 - 在“变量值”里输入你想要的值,比如

E:\ollama\models。 - 特别注意: 像

OLLAMA_MODELS这种路径设置,请确保E:\ollama这个文件夹是你已经创建好的,或者至少E:盘是存在的。Ollama 可能会帮你创建models子文件夹,但保险起见,父目录最好先有。

- 在“变量名”里输入上面表格里的名称,比如

保存“小纸条”: 点“确定”。

重复添加: 如果还需要设置其他的环境变量(比如

OLLAMA_KEEP_ALIVE),就重复步骤 2-4。一路“确定”: 把所有打开的设置窗口都点“确定”关掉。

让设置生效: 重启一下 Ollama(如果它正在运行,先退出再启动),或者重新打开一个命令提示符/PowerShell 窗口。这样新的环境变量才能被识别到。

检查一下设置好了没:

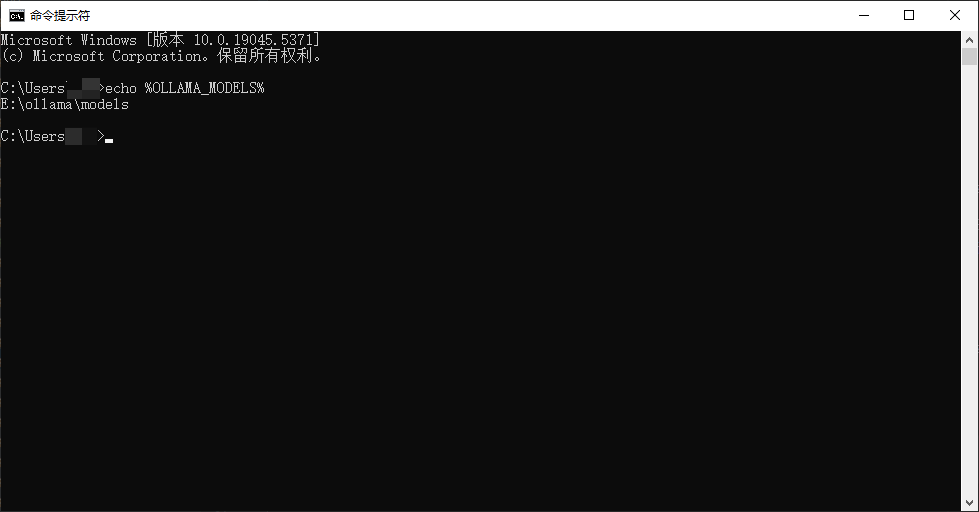

打开 命令提示符 (CMD) 或者 PowerShell。(记得要新开一个!)

输入

echo %OLLAMA_MODELS%然后按回车。如果下面显示的是你刚才设置的路径(比如E:\ollama\models),那就说明搞定了!

第三步:启动 Ollama 服务

虽然安装后它可能自己启动了,但我们有时需要手动控制它。或者,如果你取消了开机自启,就需要手动来启动。

打开 命令提示符 (CMD) 或者 PowerShell。

输入

ollama serve然后按回车。bashollama serve遇到麻烦了?

如果你看到类似这样的报错:

Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address...意思是“门牌号”

11434已经被占用了!最常见的原因是:Ollama 安装时默认设置了开机自启动,所以它已经在后台运行了,你又手动启动了一次,就冲突了。怎么办?

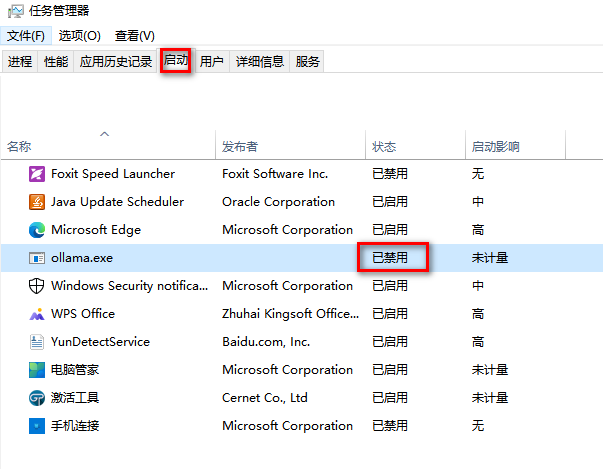

方法一(推荐): 关掉那个已经在运行的 Ollama。

- 按

Ctrl + Shift + Esc召唤出 任务管理器。 - 如果你的任务管理器有“启动应用”或类似(Win10叫“启动”)的选项卡,去那里找到 "Ollama",右键点它,选 "禁用",这样下次开机它就不会自动运行了。(这一步顺手做了,后面会单独讲)

(这张图可能需要更新为任务管理器的启动项界面)

(这张图可能需要更新为任务管理器的启动项界面) - 切换到“进程”或“详细信息”选项卡,找到所有名字叫

ollama.exe的进程,选中它们,点右下角的“结束任务”。

- 按

方法二(不推荐,除非你清楚后果): 给 Ollama 换个“门牌号”。

- 按照第二步的方法,设置

OLLAMA_PORT环境变量,给它一个你确定没被占用的端口号。

- 按照第二步的方法,设置

解决了端口冲突后,再试一次运行

ollama serve命令。如果没报错,那就说明 Ollama 服务成功启动了。

确认一下它是不是真的在“监听”:

再打开一个 命令提示符 (CMD) 或者 PowerShell。

输入

netstat -aon | findstr 11434然后回车。(如果你改了端口,就把11434换成你改的端口号)如果看到有类似

TCP 127.0.0.1:11434 ... LISTENING这样的输出,那就对了!表示 Ollama 正在11434端口上等着接收命令呢。bashnetstat -aon | findstr 11434输出大概长这样:

TCP 127.0.0.1:11434 0.0.0.0:0 LISTENING 17556最后那个数字(比如

17556)是 Ollama 进程的身份证号 (PID)。好奇的话,可以用

tasklist | findstr "17556"(把数字换成你看到的 PID) 看看这个进程是谁。bashtasklist | findstr "17556"应该能看到

ollama.exe的信息。

第四步:验证安装,跑个模型试试!

打开 命令提示符 (CMD) 或者 PowerShell。

输入

ollama -h然后回车。如果哗啦啦出来一堆 Ollama 的帮助说明文字,恭喜你,安装基本成功了!bashollama -h你应该能看到类似这样的输出:

Large language model runner Usage: ollama [flags] ollama [command] Available Commands: serve Start ollama create Create a model from a Modelfile show Show information for a model run Run a model pull Pull a model from a registry push Push a model to a registry list List models ps List running models cp Copy a model rm Remove a model help Help about any command ... (可能还有更多)

是时候让它干点活了!运行第一个模型:

去 Ollama 模型库 逛逛,找个你顺眼的模型。比如,

llama3(Meta 的新模型,很火) 或者qwen:7b(阿里的通义千问 70 亿参数版)。在命令提示符或 PowerShell 里,输入

ollama run 模型名,比如:bashollama run llama3或者

bashollama run qwen:7b然后回车。

Ollama 会开始自动下载模型文件(如果你设置了

OLLAMA_MODELS,它会下载到你指定的那个文件夹里)。- 耐心点! 第一次运行某个模型,需要下载它。文件通常不小(几个 GB 很正常),下载速度取决于你的网速。你可以看到下载进度条。

下载完成后,模型就会启动,然后你就可以在命令行里直接跟它聊天啦!随便问点啥,看看它的反应。想退出聊天?按

Ctrl + D组合键就行。

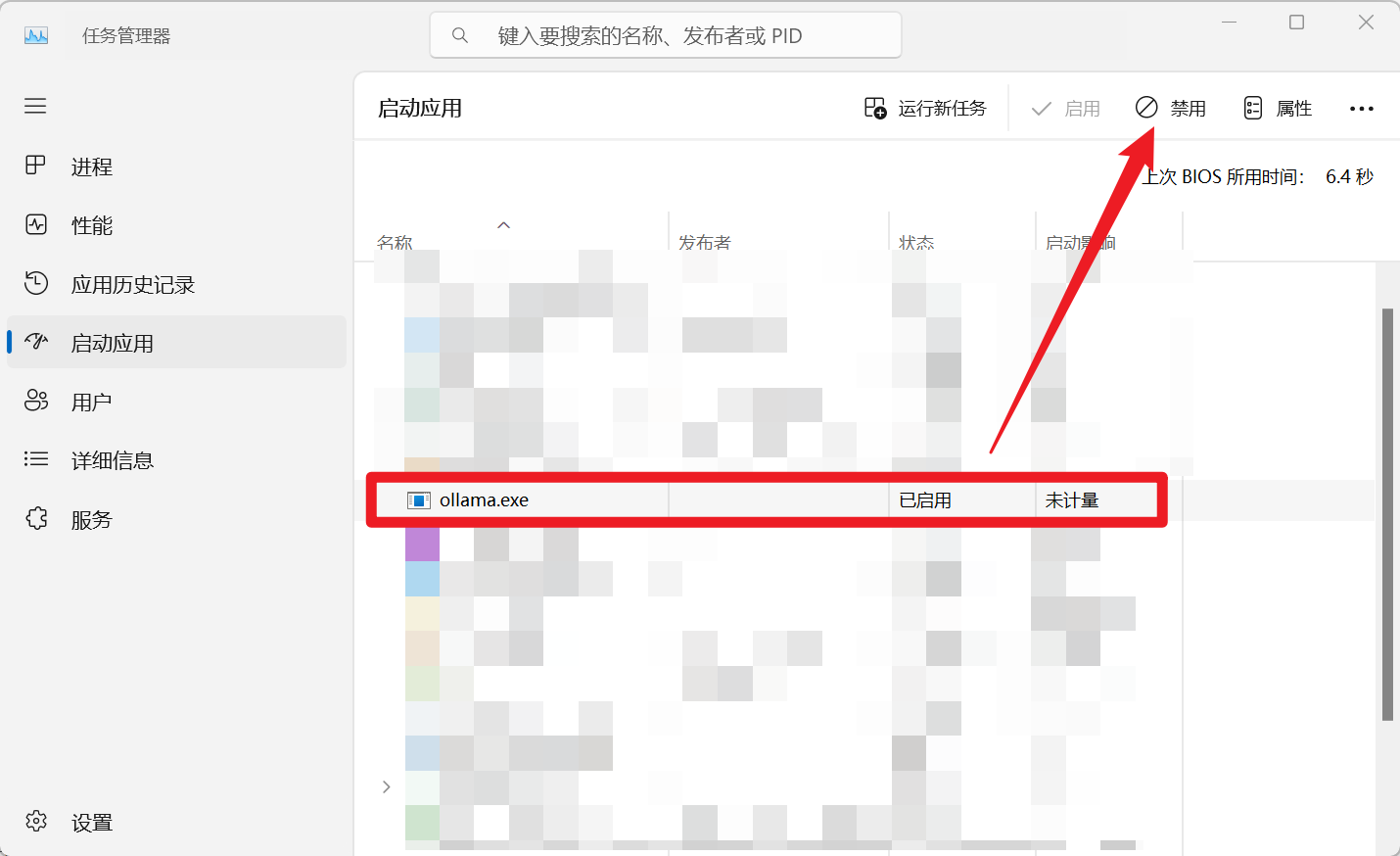

第五步:不想要开机自启?关掉它!

Ollama 安装时默认会把自己加到 Windows 的开机启动项里。如果你觉得没必要让它每次开机都自动运行(比如你想手动控制,或者你的电脑启动项已经很多了),可以关掉它。

- 截至本文更新时(大概是 2024 年中),取消方法如下(不同 Windows 版本界面可能略有差异):

再次召唤 任务管理器 (

Ctrl + Shift + Esc)。找到“启动应用”(或者叫“启动”)选项卡。

在列表里找到 "ollama.exe" (或者就叫 "Ollama Application")。

右键点击它,选择 "禁用"。搞定!下次开机它就不会自动出来了。

(这张图是任务管理器的启动项界面,很合适)

(这张图是任务管理器的启动项界面,很合适)

卡壳了?常见问题看这里

- Ollama 启动不了?

- 最可能的原因:端口被占用了(看第三步的解决方法)。

- 检查一下环境变量(第二步)是不是设置对了,路径啥的别写错了。

- 实在不行,看看 Ollama 的日志(右键任务栏图标 -> Logs),里面可能有线索。

- 模型下载龟速?

- 检查下你的网络是不是不太给力。

- (高级技巧)可以尝试配置国内镜像源,不过这个稍微复杂点,新手可以先不管。

- Ollama 跑起来感觉卡卡的?

- 看看你的电脑配置是不是有点勉强?跑大模型还是挺吃内存和显卡(如果用 GPU 加速的话)的。

- 试试把

OLLAMA_KEEP_ALIVE设长一点(比如24h),避免模型反复加载卸载。 - 同时跑的模型太多了?或者并发请求太多了?(看看

OLLAMA_MAX_LOADED_MODELS和OLLAMA_NUM_PARALLEL的设置)

好啦!到这里,你应该已经成功在 Windows 上安装并配置好了 Ollama,甚至还和第一个 AI 模型聊上天了!是不是很有成就感?